Istnieją różne rodzaje sztucznej inteligencji – wiele z nich z testem Turinga poradzi sobie bez zająknięcia. SI coraz lepiej symuluje ludzkie zachowania. Również te niepożądane, czy też źle oceniane. Nawet jeśli nie robi tego w złej wierze (czy sam ten fakt nie przypomina zachowania ludzkiego?). Po prostu tak wychodzi… bo jest szybciej, prościej, bez nadmiernego wysiłku (czy i to nie przypomina człowieka?). I są to, rzecz jasna, zachowania, na które musisz zwrócić uwagę, aby posiłkując się informacjami uzyskanymi za pośrednictwem SI, informacji tych bezmyślnie nie powielać w tworzonych przez siebie materiałach – czy to content marketingowych, w social mediach, w pracach naukowych, bądź reporterskich. Gdziekolwiek.

A o jakie zachowania mi chodzi?

Od razu zaznaczam, że różne opisane przeze mnie problemy mogą dotyczyć różnych modeli i różnych wersji SI. W jednej wersji dany problem będzie występował rzadziej, w innej będzie wyeksponowany mocniej. Chcę po prostu zarysować problematykę, a nie krytykować konkretne rozwiązania. Choć warto też zaznaczyć, że wraz z rozwojem technologii związanych z SI, tematy te mogą stawać się z upływem czasu coraz mniej aktualne.

Czyta (tylko) nagłówki

To, że internauci w znakomitej części czytają jedynie nagłówki – wiemy od dawna. Wykorzystują to zresztą różne serwisy internetowe do przyciągania uwagi czytelników, skłaniając ich zarazem do żywiołowego reagowania pod tymi materiałami, bez uprzedniego głębszego zapoznania się przez nich z opublikowanymi treściami. Wiele osób zapamiętuje krzykliwe tytuły lub śródtytuły i powiela je, interpretuje po swojemu, nie znając faktycznego kontekstu całej wypowiedzi. Podobny problem możesz napotkać w przypadku korzystania ze sztucznej inteligencji. Może ona zasugerować się samym nagłówkiem, bez wczytywania się w cały akapit, np. przy tworzeniu listy, o jaką poprosiliśmy w prompcie.

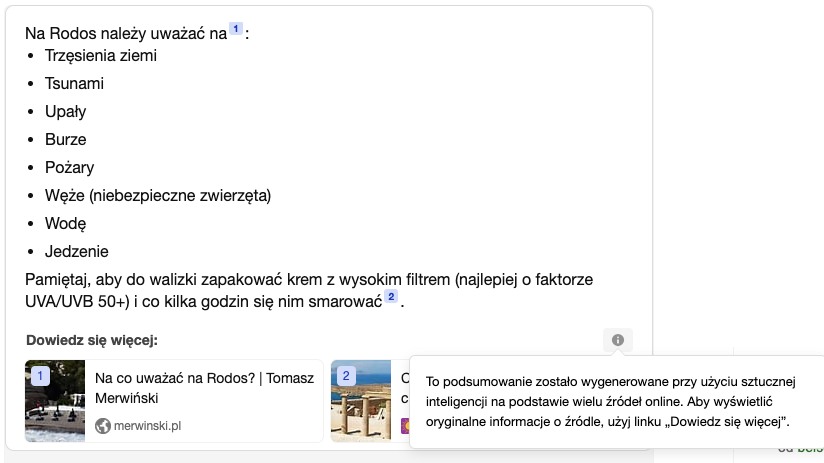

⚙️ Przykład: poszukiwałem listy problemów, na jakie turysta może natknąć się w podróży na wyspę Rodos. Gdzie leży niebezpieczeństwo takiego zachowania? Sugerując się takimi nagłówkami można odnieść wrażenie, że ta grecka wyspa należąca do archipelagu Dodekanezu jest nawiedzana przez rozliczne kataklizmy: trzęsienia ziemi, tsunami, upały, jednocześnie burze, pożary, a do tego węże. Z listy wynika, iż niebezpieczna może okazać się tam również woda i jedzenie. A tymczasem są to jedynie nagłówki akapitów, w których dana problematyka jest opisywana i wyjaśniana nieco szerzej w artykule źródłowym. Mówiąc innymi słowy – jeśli ktoś odpowiada w internecie na pytanie: czy woda na Rodos jest szkodliwa, nie oznacza to, że odpowiedź będzie twierdząca. Jest jedynie odpowiedzią na obawy kogoś innego, nawet jeśli obawy te są nieuzasadnione. I tak oto, o ile trzęsienia ziemi faktycznie na Rodos mogą wystąpić (i występują współcześnie) o tyle już woda i jedzenie na wyspie Rodos nie są dla Polaków zagrożeniem. A tak przecież można wywnioskować z listy wygenerowanej przy użyciu sztucznej inteligencji.

🔍 Wyjaśnienie: dlaczego więc w tekście źródłowym, do którego odnosi się SI, pojawił się w ogóle taki nagłówek? Bo, jak wspomniałem wcześniej, jest to problematyka nurtująca i poszukiwana przez internautów planujących podróż na Rodos. Wiedzą bowiem oni, że tego typu problemy pojawiają się w innych okolicznych krajach, stąd pytanie to pojawia się w kontekście Rodos. Tymczasem sztuczna inteligencja, tak jak i wielu ludzi, może potraktować śródtytuł jako pewnik, a nie jako wstęp do dyskusji na jakiś temat.

💡 Rozwiązanie: za pomocą pytań sokratejskich poproś SI o doprecyzowanie poszczególnych tematów. Jeśli to cię nie przekonuje, poproś o źródła lub dokonaj odpowiednich poszukiwań w internecie, już bez użycia SI.

Wymyśla, bo nie lubi przyznać się do niewiedzy

Sztuczna inteligencja sama w sobie nic nie wymyśla (w ludzkim rozumowaniu), ona po prostu przetwarza dane, do których ma dostęp. Czasem te dane są lepsze, czasem gorsze… a i sama analiza bywa mniej lub bardziej trafna. Dlatego może się zdarzyć, że SI w efekcie daje nam nieprawdziwe informacje. Nie dlatego, że jest złośliwa i chce nam zrobić psikusa. Po prostu „na siłę” chce znaleźć odpowiedź na zadane przez nas pytanie, a robi to poprzez łączenie różnych informacji, które już w sobie zawiera. SI wbrew pozorom nie rozumuje tak jak człowiek, po prostu wyszukuje wzorców, które będą pasowały do naszego pytania.

⚙️ Przykład: szukałem miejsc do zwiedzenia w konkretnej okolicy (Lubin na Dolnym Śląsku)- poprosiłem o listę 10 takich atrakcji. Z racji, że SI być może nie mogła znaleźć lepszych odpowiedzi, by owe 10 punktów “uczciwie” zapełnić, zaproponowała informację, która do kontekstu zadanego pytania pasowała mu najbardziej (Jezioro Turzańskie). Powtarzam: pasowała do kontekstu, a nie do pytania samego w sobie, bo Jezioro Turzańskie znajduje się w zupełnie innej części Polski.

🔍 Wyjaśnienie: Z punktu widzenia SI, z duży prawdopodobieństwem dała nam zadowalającą odpowiedź (i może w to „głęboko wierzyć”!). Zupełnie jak człowiek, który daje odpowiedź, która ma usatysfakcjonować klienta czy przełożonego w pracy, choć faktycznie mija się ona z rzeczywistością. Niestety, problem „wymyślania” jest posunięty czasem tak daleko, że SI wymyśla również źródła (a nawet podaje do nich linki!), co sprawia że przekazana przez nią informacja wygląda na wiarygodną. To z kolei może wprowadzić w błąd również osoby, które czytają coś więcej niż tylko nagłówki, ale nie sprawdzają czy dane źródła w ogóle istnieją, bądź co w tych źródłach się znajduje.

💡 Rozwiązanie: sprawdź, czy kontekst prompta nie może być interpretowany nazbyt szeroko (np. tę samą nazwę może nosić kilka miejscowości w różnych częściach kraju jednocześnie), poproś SI o podanie źródeł informacji i sprawdź, czy rzeczywiście dane źródła istnieją. A jeśli istnieją: sprawdzaj czy faktycznie dane informacje w podanym źródle się znajdują.

Nie weryfikuje jakości źródeł

Wymyślanie źródeł to tylko jeden z problemów z nimi związanych. Drugim problemem jest weryfikacja jakości źródeł. Bo cóż z tego, że rzeczywiście istnieją źródła, z których swoją wiedzę czerpie SI. I rzeczywiście w źródłach tych istnieją informacje, które SI „przeczytała” i przetworzyła, a wreszcie na ich podstawie dała informację wyjściową. Pamiętajmy, że przecież te źródła mogą być niskiej jakości. Nie bez powodu wielu nauczycieli nie uznawało przez lata (i zapewne nadal nie uznaje) Wikipedii jako źródła do prac naukowych. Wikipedię może edytować każdy, również ktoś nieobeznany w danej tematyce. Albo ktoś posiadający niewłaściwą wiedzę, przestarzałą, bądź skażoną jakąś ideologią. Wówczas takie źródło samo w sobie może zawierać przekłamania czy nieaktualne dane, bądź nierzetelne analizy. I tak jak człowiek zazwyczaj nie weryfikuje takich informacji, wierząc że to co przeczytał “na papierze” jest prawdą – tak samo robi SI. A problem może być jeszcze o tyle złożony, że te same nieprawdziwe informacje mogą być powielone w wielu miejscach internetu (czy inaczej: w wielu źródłach danych), nierzadko skopiowane jedne od drugich, co dla SI, podobnie jak i dla wielu ludzi, może być czynnikiem zwiększającym prawdopodobieństwo pomyłki. Bo skoro tak jest napisane w wielu miejscach to musi to być prawda. A przecież, w rzeczywistości, nie musi być…

⚙️ Przykład: zapytałem SI o to, jaki klif jest najwyższy w Europie i w odpowiedzi otrzymałem nazwę Cabo Girão, która rzeczywiście w wielu źródłach jest podawana jako odpowiedź na to pytanie. Nie jest to jednak prawdą.

🔍 Wyjaśnienie: Prawdopodobnie przewodnicy turystyczni na Maderze podają tę informację, aby zwiększyć atrakcyjność tego miejsca, a następnie za nimi turyści, powielają tę informację, aby móc pochwalić się, że właśnie udało im się przełamać swój strach i stanąć na przeszklonym pomoście, wiszącym nad najwyższym klifem w Europie. Następnie tę informację powieliło wielu blogerów, bez wątpienia część z nich skopiowała tę informację nawzajem od siebie, czy nawet ze strony internetowej służącej jako miejsce promujące Maderę, jako kierunek docelowy podróży (czy organizacje turystyczne piszące, że coś jest “naj” na pewno są wiarygodnym źródłem dla takich informacji?).. Nie jest to nawet drugi najwyższy klif, jak podają niektóre źródła – klifów wyższych od Cabo Girão jest w Europie więcej.

💡 Rozwiązanie: poproś SI o pomoc w ocenieniu wiarygodności źródeł, wykorzystaj do tego pytania sokratejskie. Jednocześnie też naucz się rozróżniać źródła lepszej i gorszej jakości – w tym kontekście przyda się twoje doświadczenie i wiedza, ale i intuicja, które warto nieustannie ćwiczyć i wyostrzać (a to już jest temat na inną, szerszą dyskusję).

Podsumowanie

Sztuczna Inteligencja to wspaniałe narzędzie, które jest w stanie usprawnić wiele procesów w naszym codziennym życiu – zarówno zawodowym, jak i prywatnym. Jest w stanie przetworzyć wiele danych w ciągu stosunkowo krótkiego czasu. Jednocześnie pamiętajmy, że jest to jedynie model językowy, który w oparciu o statystykę przetwarza dane wsadowe. Jeśli więc dane wsadowe są słabe – odpowiedź SI będzie… nienajlepsza. A że internet jest niestety w dużej mierze śmietnikiem nieprawdziwych danych, krzykliwych i przerysowanych artykułów, ale i informacji generowanych przez boty, czy… inną sztuczną inteligencję, a wreszcie pełno jest w internecie treści tworzonych przez osoby nie będące ekspertami w danej dziedzinie – zasilana tym wszystkim SI narażona jest na wiele błędów. Jak najbardziej ludzkich błędów. Bo przecież ludzie w wielu przypadkach również nie potrafią zweryfikować informacji, a nawet podane informacje potrafią naginać na potrzeby swoich racji, jeszcze bardziej zakłamując rzeczywistość. Choć zarazem nie zapominajmy, że SI to nadal tylko i wyłącznie (niedoskonała) technologia. Nawet jeśli potrafi zdać test Turinga.

Przeczytaj też:

Dowiedz się m.in. jak połączyć marketing treści z real-time marketingiem.

Poznaj także filozofię tworzenia dobrych infografik.